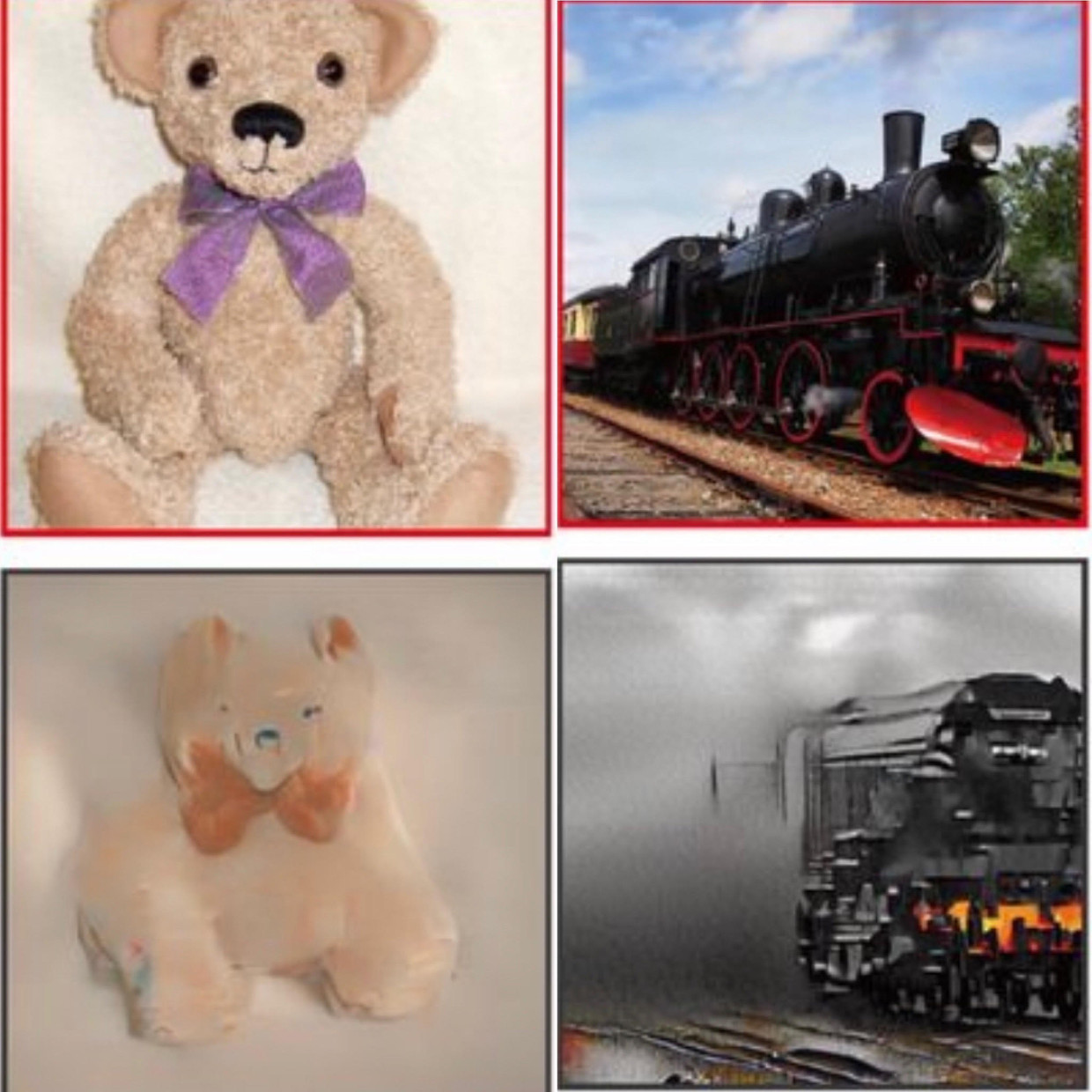

Guarda, lì, una foto di una locomotiva a vapore nera contro un cielo leggermente nuvoloso. O guarda quell’orsacchiotto con il suo fiocco viola. Tutto accade dal momento in cui i nostri occhi vedono una locomotiva o un orso. La percezione visiva va prima alla parte del cervello responsabile della prima interpretazione approssimativa: linee e contrasti. Quindi passa ad altre sezioni, che trattano informazioni più complesse e significative. Questo è il modo in cui il nostro cervello struttura in modo massiccio le informazioni presentate per formare infine un’immagine significativa.

Succede tutto nella nostra testa, e oggi gli scienziati possono dare un’occhiata dentro. I loro sforzi possono fornire maggiori informazioni su come funziona il cervello umano e possono aprire la strada a nuove tecnologie. Pertanto, i pazienti paralizzati che non possono più parlare possono comunicare con i loro cari attraverso i loro pensieri.

Ma tornando prima a quella locomotiva ea quell’orso, si presentano in forma di a Esperienza recente all’Università di Osaka in Giappone. Usano misurazioni fMRI, che possono registrare la posizione esatta dell’attività cerebrale. I soggetti del test giacciono in un tunnel di scansione mentre devono guardare un gran numero di immagini. Questi provengono da un set di dati noto di diecimila immagini di persone, paesaggi e oggetti, comprese le loro descrizioni.

Circa l’autore

Laurens Verhagen descrive De Volkskrant A proposito di tecnologia, Internet e intelligenza artificiale.

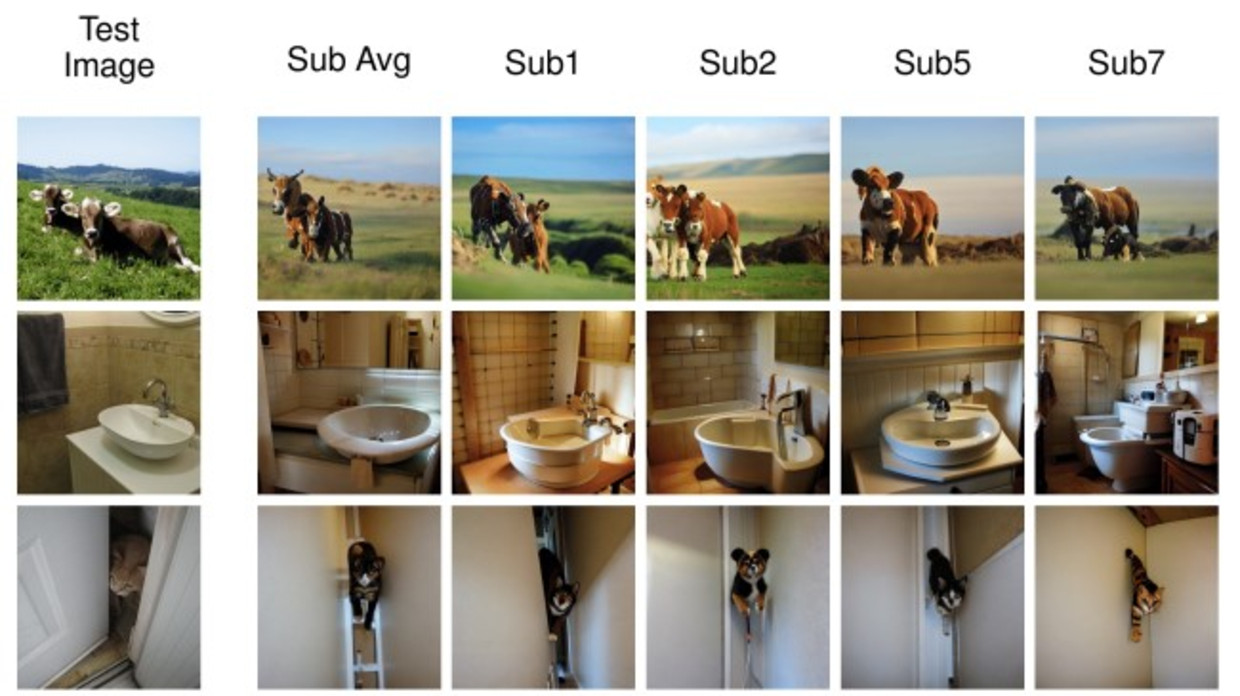

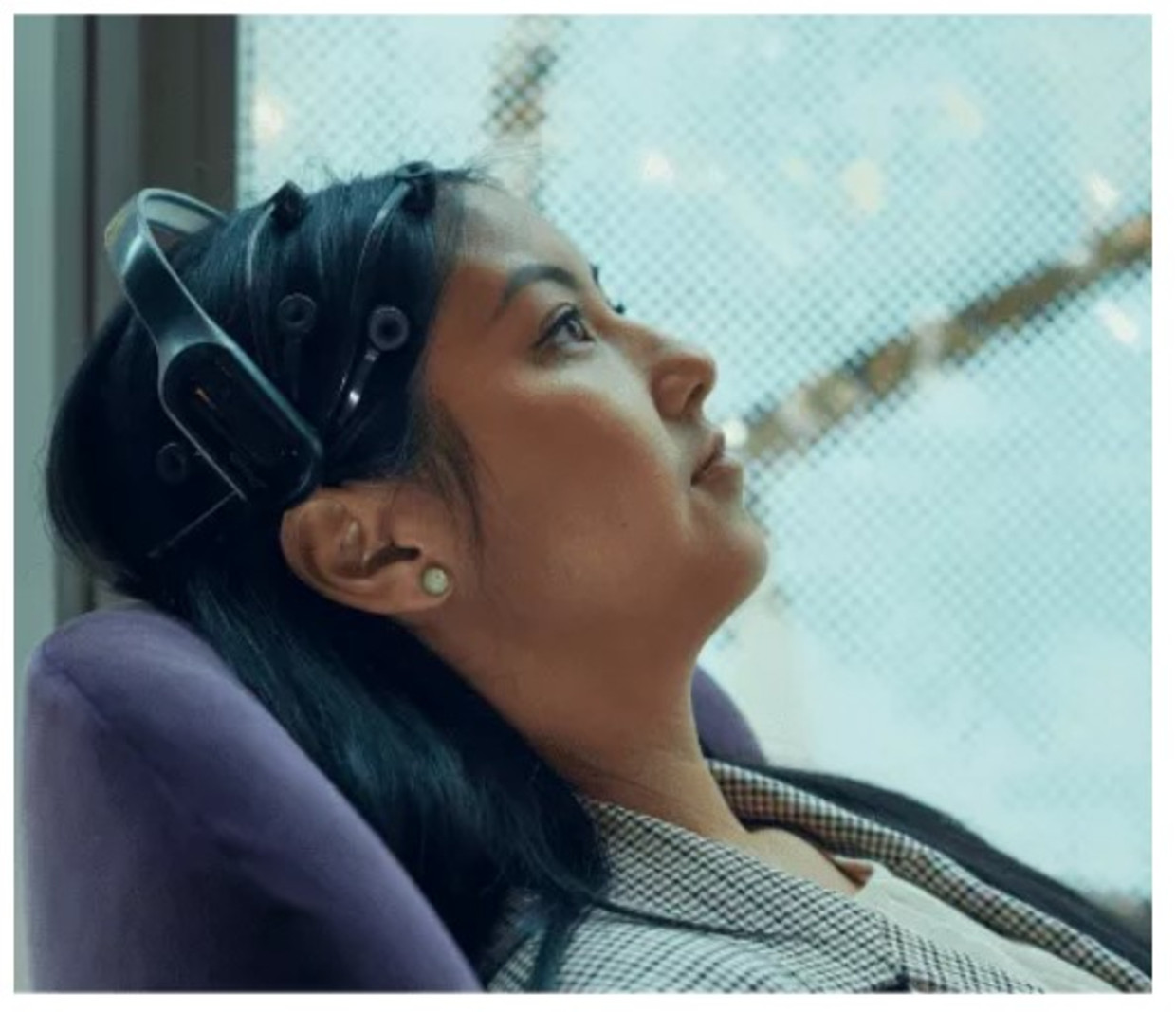

Rispetto a una misurazione EEG più accessibile (un tipo di cuffia da doccia con elettrodi), il segnale fMRI individua in modo più accurato dove si sta verificando un’attività specifica. In questo caso, ci sono due aree del cervello: quella che elabora i segnali visivi e quella responsabile della creazione di sensi. I ricercatori hanno collegato queste misurazioni a un modello di intelligenza artificiale già addestrato, che consisteva in diecimila immagini più descrizioni.

In questo modo, i ricercatori sono stati in grado di stabilire connessioni tra i dati fMRI dall’area del cervello guidata visivamente e le immagini originali che le persone stavano visualizzando. Hanno fatto lo stesso con i dati fMRI della regione del cervello che elabora il significato delle immagini e le attuali descrizioni testuali delle immagini.

Nella ricerca precedente è stato utilizzato solo il primo tipo di informazione (visiva), ma anche includendo e integrando dati provenienti da altre regioni cerebrali (strutturali), i ricercatori ottengono una ricostruzione migliore e più dettagliata: nessun punto sfocato, ma una vera bambola tenendo un arco. Anche ricercatori dell’Università di Tolosa descritto di recente Sviluppi simili con immagini più nitide.

L’uso delle misurazioni fMRI non è una novità, ma lo è il collegamento dei cosiddetti modelli di diffusione alle misurazioni. Si tratta di una branca dell’intelligenza artificiale che negli ultimi mesi è diventata nota al pubblico con nomi come DALL-E, Stable Diffusion e Midjourney. Questi programmi di intelligenza artificiale possono generare immagini basate sull’input di testo.

Marcel van Gerven, professore di intelligenza artificiale alla Radboud University che non è stato coinvolto in nessuno di questi studi, è rimasto impressionato dalle ultime scoperte: “Questo è un buon passo verso una ricostruzione sempre migliore”. Lo stesso Van Gerven lo ha fatto al Donders Institute for Brain, Cognition and Behaviour della Radboud University ricerca similema senza i modelli di diffusione che sono così popolari ora.

Anche Iris Groene, assistente professore di neuroscienze computazionali all’Università di Amsterdam, ha elogiato la combinazione delle misurazioni fMRI esistenti con gli ultimi robusti modelli di intelligenza artificiale. Le immagini ricostruite del cervello sono state descritte come impressionanti. Ma avverte anche: “Il fatto che le immagini presentate e ricostruite corrispondano così strettamente non significa che ora improvvisamente sappiamo esattamente come funziona l’elaborazione delle immagini nel nostro cervello”. L’altro lato della medaglia è interessante, dice van Gerven: “Come si progettano sistemi di intelligenza artificiale che si comportano proprio come gli umani, che sono efficienti quanto il nostro cervello, proprio come una forza?”

Il passo successivo è ovvio: la vera lettura della mente. Entra nello scanner e pensa a qualcosa, solo senza alcuno stimolo visivo. Oppure: addormentarsi e iniziare a sognare. Un computer potrebbe quindi tradurre i segnali cerebrali in qualcosa di significativo? Un modello di intelligenza artificiale generativa potrebbe trasformarlo in un film meravigliosamente surreale? “È vero che si stanno facendo ricerche su questo, ma siamo ancora molto lontani dall’essere arrivati”, Groen tempera le aspettative troppo alte.

Anche Van Gerven è cauto, ma allo stesso tempo osserva che gli sviluppi si stanno muovendo rapidamente, non solo nell’aspetto dell’intelligenza artificiale, ma anche nel campo delle misurazioni. Il Donders Institute ha recentemente ricevuto una sovvenzione di 19 milioni di euro per costruire lo scanner MRI più potente al mondo per dati cerebrali più dettagliati.

lettera

La cosiddetta apparecchiatura di misurazione invasiva va ancora oltre. Non ci sono cuffie da doccia o scanner MRI, ma c’è un impianto intracranico per misurazioni cerebrali più accurate. Julia Berezutskaya, ricercatrice presso il Donders Institute e UMC Utrecht sulle cosiddette interfacce cervello-computer, sta usando questi tipi di impianti in un altro tentativo di ricostruire l’attività cerebrale: non immagini, ma parole.

In una recente ricerca di Berezutskaya e del suo team, si sono concentrati su altri tipi di ricerca in cui i pazienti con epilessia grave avevano già ricevuto impianti. Berezutskaya è stato anche in grado di effettuare misurazioni durante i suoi sette giorni di permanenza nell’unità di terapia intensiva dell’UMC Utrecht. Il grande vantaggio: “eccellente qualità del segnale” e quindi “risultati di decodifica accurati”.

Il punto di partenza è quasi lo stesso della ricerca per immagini, ma con il parlato. I soggetti leggono ad alta voce un totale di dodici parole olandesi, origine Jeb e Janick, come “nonna”, “scegli”, “tutto”, “yip”, “me” e “cappello”. Anche qui il trucco è decodificare le stesse parole dal segnale cerebrale ricevuto.

Questo funziona bene ora. “Ma prevedere singole parole dai segnali cerebrali è, ovviamente, molto diverso da intere frasi”, afferma Berezutskaya. Questo è ancora un grande passo, ma non impossibile. Anche l’intelligenza artificiale può dare un contributo importante a questo tipo di ricerca. Si riferisce ai modelli linguistici così come sono conosciuti dal grande pubblico di ChatGPT. Fondamentalmente quello che fanno è prevedere la parola successiva ogni volta. Usando questo tipo di intelligenza artificiale combinata con misurazioni cerebrali dettagliate, dovrebbe essere possibile ricostruire frasi.

Nonostante gli impressionanti progressi compiuti da questi tipi di modelli linguistici, Berezutskaya vede ancora alcuni ostacoli sulla strada. Dopotutto, rimangono modelli probabilistici, modelli che fanno previsioni basate sulla probabilità. Dobbiamo bilanciare velocità e praticità da un lato e precisione dall’altro. Quante volte è permesso a un computer di ricostruire una frase che in realtà non intendevi dire?

È più facile immaginare le applicazioni pratiche della ricostruzione del parlato piuttosto che delle immagini. Pensa ai pazienti che non riescono più a controllare la loro parte del discorso perché sono completamente paralizzati. Una ricerca simile negli Stati Uniti ha già prodotto un computer vocale per un paziente americano che non era più in grado di parlare dopo un’emorragia cerebrale. La differenza con lo studio olandese è che il paziente deve scriverlo lettera per lettera in questo ordine.

George Orwell

La strada per l’inferno è lastricata di buone intenzioni. Con questo detto in mente, Pim Haselager, professore di intelligenza artificiale alla Radboud University, sta seguendo da vicino questo tipo di sviluppi. È fantastico, ovviamente, se i pazienti paralizzati possono essere aiutati con la neurotecnologia, ma Haselager teme anche abusi (commerciali) e una nuova classe di problemi di privacy.

“Non hai altro che pochi centimetri cubi nel tuo cranio.” citazione da 1984 Di George Orwell Importante per Haselager. L’interno del suo cranio è l’unico posto in cui il personaggio principale Winston Smith rimane al sicuro dall’intrusione della Psicopolizia e del Partito. Ma anche questo luogo che 75 anni fa era considerato sicuro ora fa trapelare informazioni.

“Non puoi fermare la tecnologia, ma quello che puoi davvero fare è riflettere attentamente sulle conseguenze della neurotecnologia e emanare leggi ove necessario”. È un ruolo difficile per lui giocare con questo, secondo lo stesso filosofo: “Identifico problemi che ancora non esistono”.

Allo stesso tempo, il futuro in cui questo tipo di tecnologia diventerà ampiamente disponibile non è lontano. Haselager si riferisce alle cuffie EEG che i consumatori possiedono già da molto tempo Può comprare poche centinaia di euro per leggere le loro menti. Sembrano degli strani auricolari e non è ancora possibile dare più di semplici comandi, ma Haselager si aspetta che cambi. Anche perché la Silicon Valley da tempo punta sulle connessioni cervello-computer, ad esempio per alimentare apparecchiature direttamente con pensieri alla velocità della luce. “Se vengono coinvolti tipi come Elon Musk e Mark Zuckerberg, sai che può diventare enorme”, prevede Haselager.

Non dobbiamo commettere lo stesso errore commesso nei primi giorni dell’Internet commerciale. Poi abbiamo dato la nostra privacy alle grandi aziende tecnologiche, dice il prof. Sostiene l’accesso nevrotico, come estensione dei diritti umani. “Cosa succede ai nostri dati cerebrali quando indossiamo un auricolare EEG? Chi ha accesso a quei dati? Puoi usare questo tipo di tecnologia per rilevare le bugie? Penso che tu debba inquadrare esplicitamente ciò che è consentito e in quale contesto. Chiama it libertà cognitiva: il diritto di tenere per sé i propri pensieri.

Van Gerven concorda: ‘Grazie all’intelligenza artificiale, gli sviluppi tecnologici si stanno muovendo alla velocità della luce. Il governo dovrà sorvegliare i confini.

“Fanatico della musica. Risolutore di problemi professionale. Lettore. Ninja televisivo pluripremiato.”

:format(jpeg):background_color(fff)/https%3A%2F%2Fwww.manners.nl%2Fwp-content%2Fuploads%2F2024%2F08%2FDit-voedsel-zit-vol-eiwitten-en-de-overheid-duwt-het-door-onze-strot.jpg)

/s3/static.nrc.nl/wp-content/uploads/2024/08/28110045/data120733791-24ece4.jpg)